Запрети мне псевдолейблить

Сутра:

1. Kaggle решат

2. Соревы обозреват

3. Gold фармить

4. Социальност

Канал о пути к Kaggle competitions Master, баварских сосисках и пиве, которым обливаешься в процессе

https://www.kaggle.com/asimandia

Для вопросов: @dimitriy_rudenko Related channels | Similar channels

2 093

subscribers

Popular in the channel

Всем приветики. Давно не было постов, тк становится всё сложнее вести канал. Не буду обещать что ...

Системы рейтинга слишком аддиктивны. Летом наконец-то смог апмнуть ммр выше, чем в свои 16 лет и...

Был бы только что закончившим магу, сам бы подался. Возможность топ, даже не думайте пропускать, ...

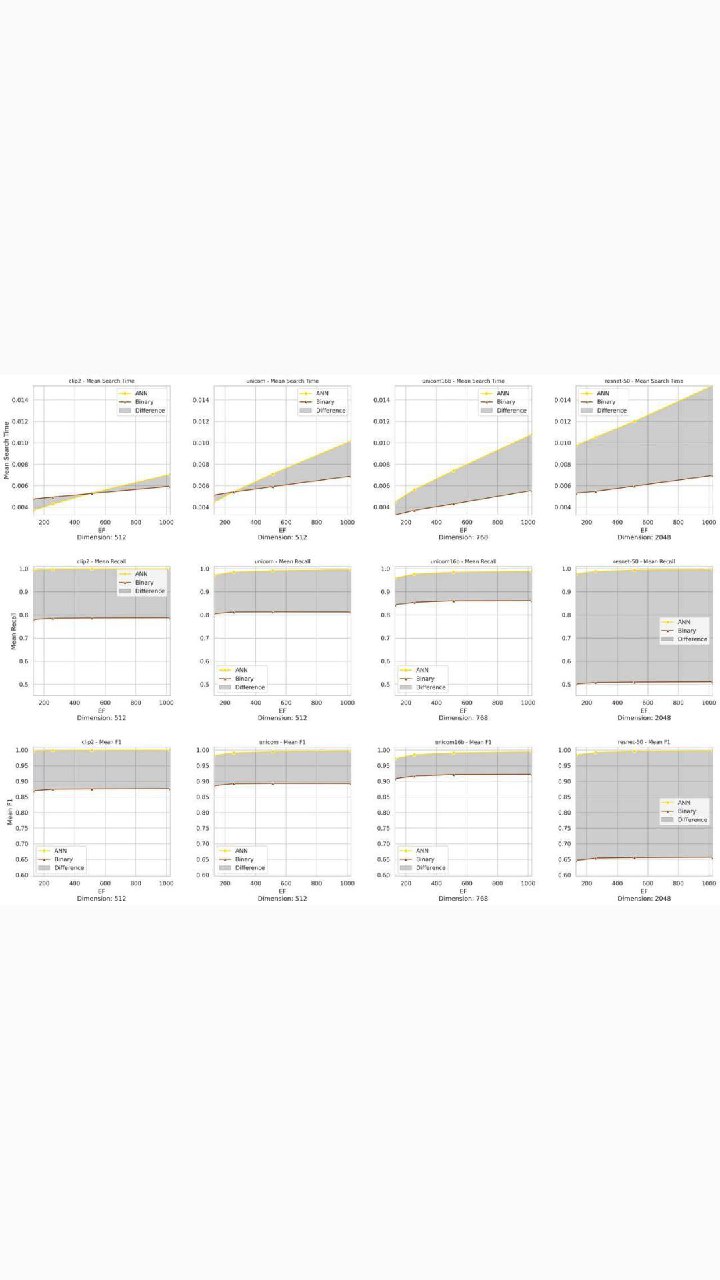

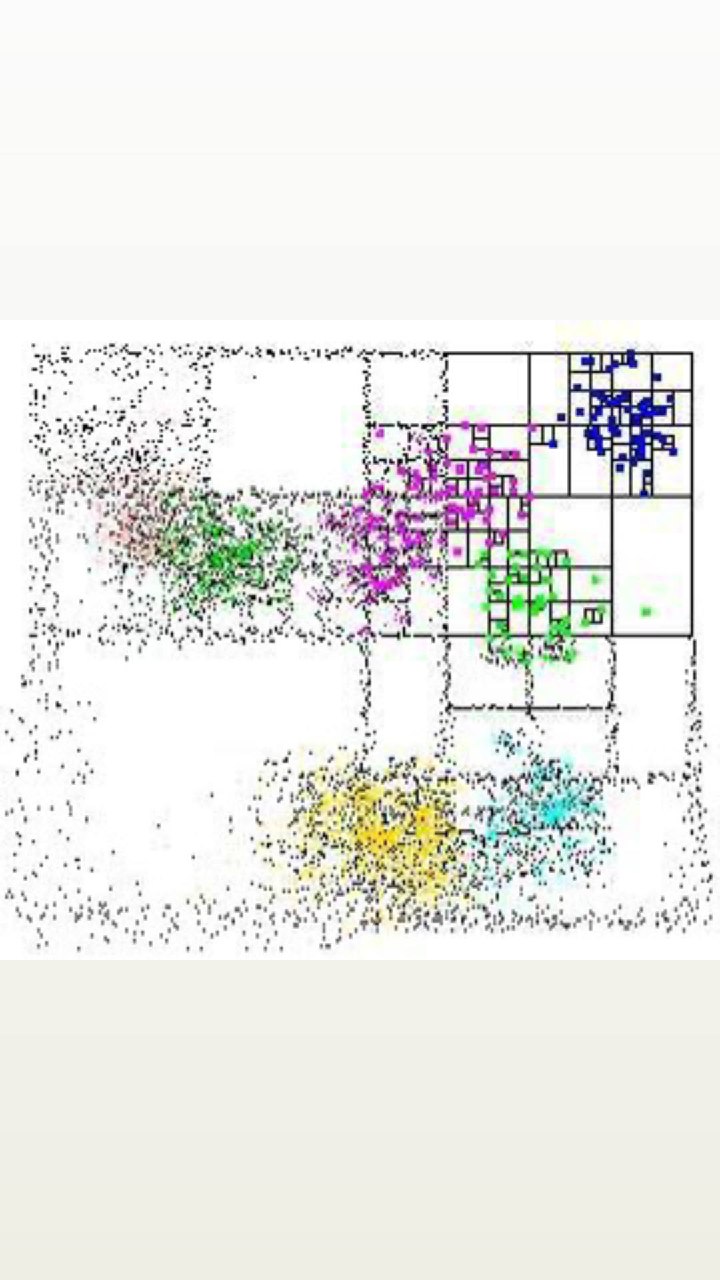

Наше комьюнити хостит сореву ☝️. Я пока топ 1 на лб с первого же сабмита. Главный приз- соавторс...

Забыл вам сказать подписчики. Видимо это сейчас важно. Все это время мне было 17 лет Админу LDT ...