AI для Всех

Канал, в котором мы говорим про искусственный интеллект простыми словами

Главный редактор и по рекламе: @crimeacs

Иногда пишут в канал: @GingerSpacetail, @innovationitsme Связанные каналы | Похожие каналы

12 904

подписчиков

Популярное в канале

🔍 Как быстро собрать весь код из проекта для подачи в LLM В последний месяц, по разным причинам,...

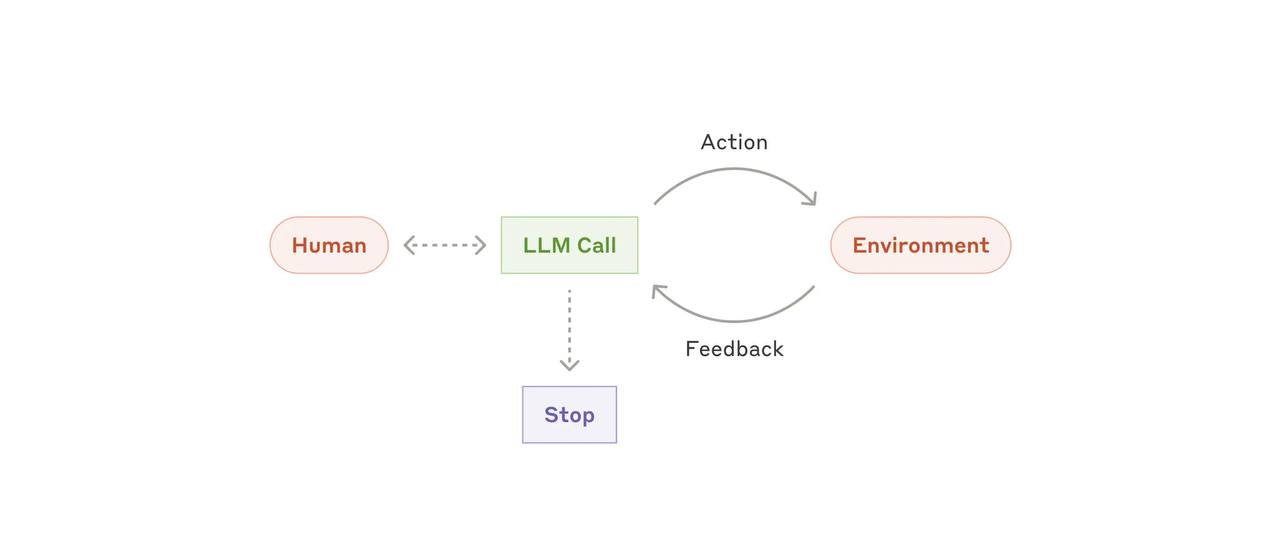

Как создавать LLM-агентов без лишней головной боли (Личный опыт и наблюдения из практики Anthropi...

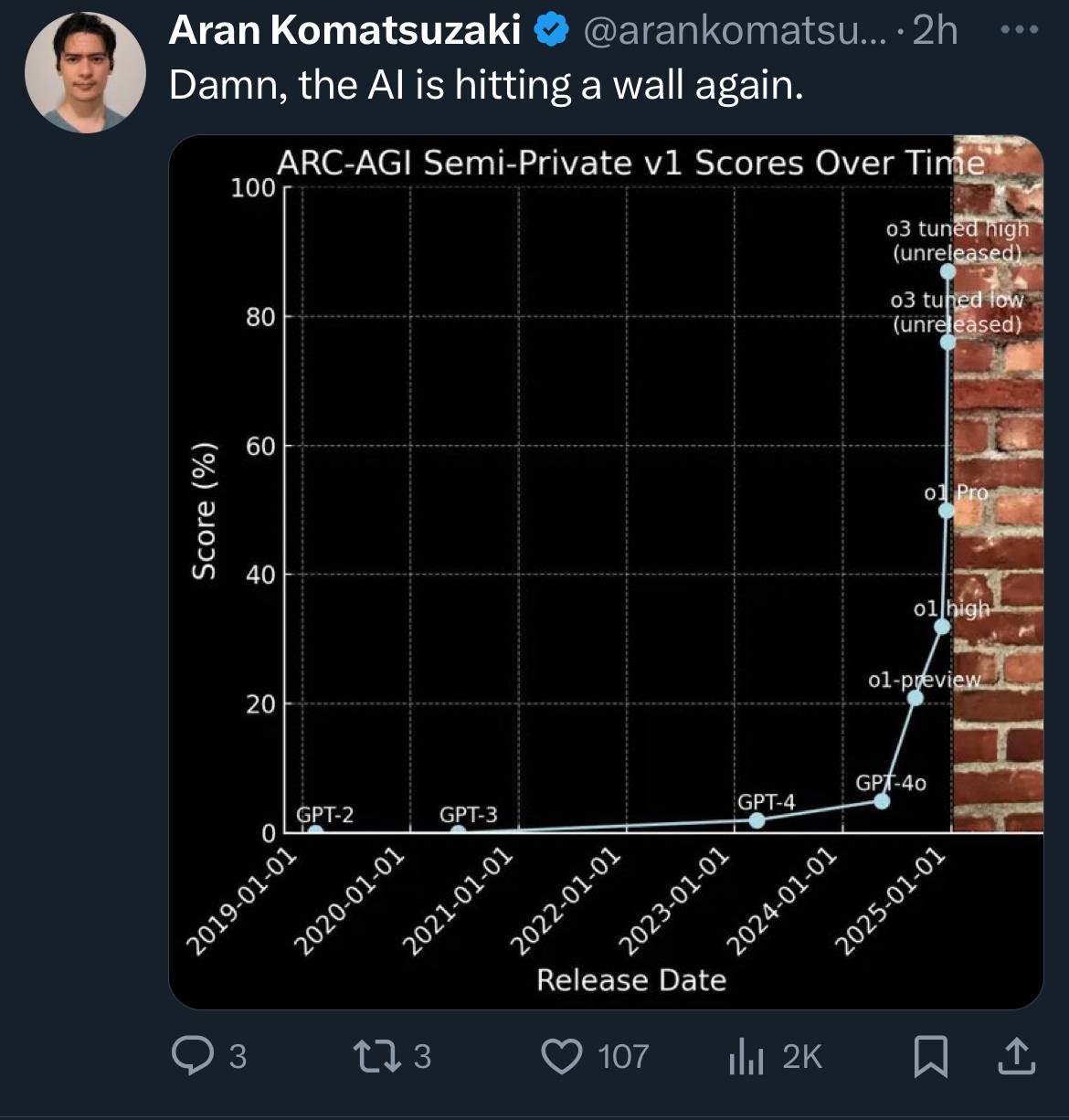

Ох уж эта стена 🤣

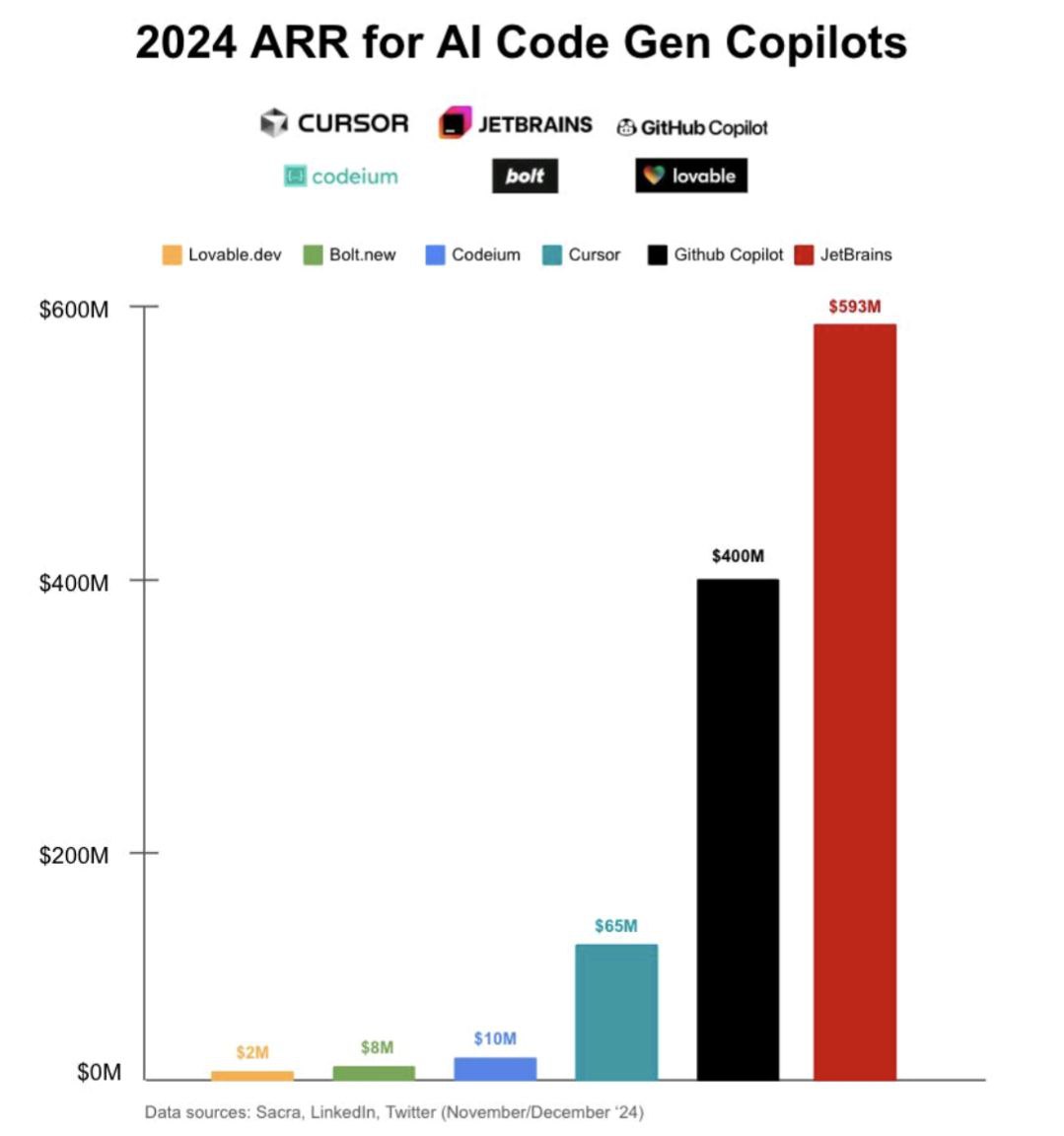

Кто из AI ассистентов для кода заработал больше всех в 2024? Oliver Molander в своем LinkedIn п...

По мнению многих (и меня в том числе), самый главный софт года - Cursor. Cursor примечателен те...