Reasoning кирпичик для StargateВ предыдущих постах я оставил закладки, которые, приводят нас к сегодняшнему посту. Итак, следите за руками. Начнем мы с конца.

В прошлом посте я дал небольшую задачку на подумать - “

Какой из промптов будет давать более точный ответ?”. Фишка там была в двух моментах.

Во-первых, на этот вопрос нельзя ответить теоретически. Да, можно упоминать головы внимания, positional encoding и кэши. Но на практике могут выстрелить совершенно другие нюансы. Правильного ответа тут нет, но есть правильный ход рассуждений:

(1) я считаю, что система будет работать так

(2) я прогнал код раз 10 и посчитал accuracy, получилось так

(3) я могу объяснить результаты так

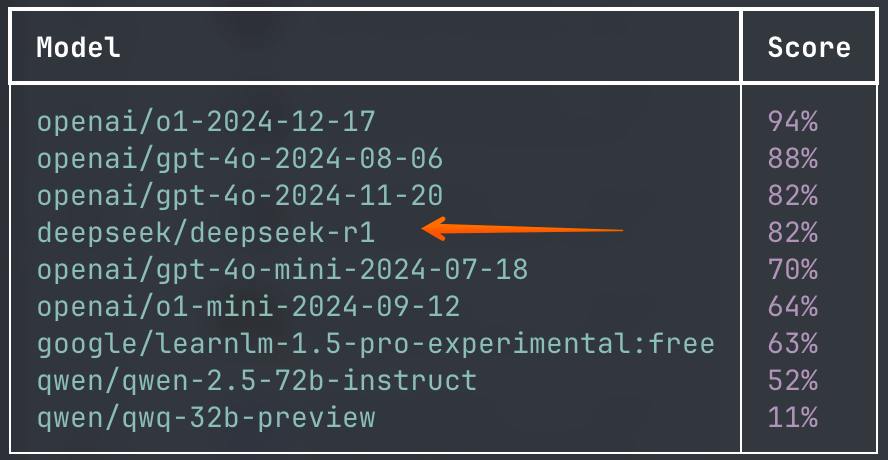

Если прогнать этот тест хотя бы раз 5, то получится такая картина:

gpt-4o-2024-11-20

Prompt q_first accuracy: 5/5 = 100

Prompt q_last accuracy: 0/5 = 0

И вот второй нюанс.

Если прогнать этот тест хотя бы на паре моделей из того же семейства, то картина может отличаться, вплоть до наоборот! gpt-4o-mini-2024-07-18

Prompt q_first accuracy: 0/5 = 0

Prompt q_last accuracy: 5/5 = 100

gpt-4o-2024-08-06

Prompt q_first accuracy: 4/5 = 80

Prompt q_last accuracy: 5/5 = 100

О чем это нам говорит? Нельзя верить только теории, как бы правдоподобно она не звучала. Нужно обязательно проверять гипотезы применительно к конкретной модели на конкретной задаче!

И если у нас внезапные нежданчики появляются на уровне простого промпта, то что можно ожидать от сложных систем, которые собираются из множества разнообразных паттернов?

Чтобы был шанс собрать стабильную систему со сложным reasoning, ее архитектура должна быть построена из достаточно простых блоков, которые можно индивидуально отлаживать, тестировать и улучшать. Чем запутанней область, тем больше усилий и времени надо потратить на аккуратное выстраивание всех цепочек.

Но если вложить время и усилия, то можно прописать reasoning. Чуть выше я писал

историю про шаги в построении своей reasoning системы. Прошлой ночью случился шаг, к которому я шел три месяца:

Шаг N: Задал тестовый compliance вопрос ChatGPT o1 pro. Он думал 2m47s и провалился в грабли, через которые мы перешагнули на 11. А мой reasoning на базе 4o за 25s пришел к правильному выводу.

На самом деле, победа не так велика - общее решение всегда будет проигрывать специализированным решениям. Но галочка в зачетке всегда приятна.

И вот тут у нас есть классное совпадение - в США новый президент как раз объявил про проект Stargate.

Это чисто

коммерческий проект по построению AI инфраструктуры на 500B USD, который организовали вместе крупные компании (причем не только из США). Государство там сбоку - ленточку перерезать и помочь с получением всяких разрешений. А бизнес - не дурак - вкладывать деньги будет только есть возможность получить отдачу. Значит, у них уже есть конкретные наработки про окупаемость.

Я думаю, что речь идет о масштабном внедрении вручную прописанных reasoning систем в разные отрасли экономики, начиная со здравоохранения, промышленности и заканчивая тем же IT.

Текущих

технологий уровня 4o уже хватает, чтобы масштабировать интеллектуальный труд специалистов достаточно высокого уровня (не заменять их, а дополнять и усиливать). Я это прочувствовал, перенося мыслительные цепочки в compliance на логические блоки в reasoning системе. А что если использовать в качестве движка не 4o а сразу o1 pro? А что если активнее использовать o1 pro или o3 pro для процесса переноса?

У нас же появляется возможность масштабировать процессы и отрасли, которые раньше упирались в банальную нехватку специалистов! И вот тут начнется самое интересное. Скорее всего, это будущее и увидели те компании, которые рискнули вложить немаленькие суммы в проект Stargate.

Но если прищуриться в детали реализации всех этих проектов, мы все равно вернемся к

аккуратному построению reasoning систем из небольших тестируемымых логических блоков с LLM под капотом. И тут

работы более чем хватит всем.

Ваш,

@llm_under_hood 🤗

PS: История заканчивается

эпизодом IV про визуализацию цепочек.